A Inteligência Artificial já é parte essencial da transformação digital nos serviços financeiros. Em processos como os de combate a fraudes, personalização de experiências, automação e reforço ao compliance, a IA tem revolucionado a forma como as instituições financeiras operam, tomam decisões e se relacionam com os clientes. À medida que a tecnologia avança, cresce também a necessidade da regulamentação da IA para garantir seu uso ético, seguro e transparente.

Governos e entidades reguladoras em todo o mundo se movimentam para criar marcos legais que protejam os direitos dos cidadãos e estabeleçam limites para o desenvolvimento e a aplicação desses sistemas. No Brasil, o debate sobre a regulamentação avança no Congresso Nacional, através do Projeto de Lei 2338/2023.

De fato, essa é uma necessidade urgente, mas também uma oportunidade para o mercado financeiro atuar com mais responsabilidade, segurança e confiança. Tanto que essa foi uma das questões em debate no Febraban Tech 2025, que aconteceu entre 10 e 12 de junho e teve como tema o futuro dos bancos na era da Inteligência Artificial.

Neste artigo, vamos analisar o cenário de regulamentação da IA, as implicações práticas no setor financeiro e como essa transformação pode criar um ambiente mais seguro e confiável para o mercado como um todo.

Panorama global: como o mundo está regulando a IA

A regulamentação da Inteligência Artificial avança em diferentes partes do mundo, com destaque para a União Europeia, que aprovou em 2024 o AI Act, um marco pioneiro e abrangente que adota uma abordagem baseada no risco.

Assim, sistemas de alto risco, como os usados por bancos, devem seguir regras mais rígidas, enquanto tecnologias com risco inaceitável, como o reconhecimento facial em tempo real, devem ser proibidas.

Nesse cenário, a OCDE e a ONU buscam harmonizar diretrizes internacionais para uma IA segura e centrada no ser humano. A parceria quer envolver cientistas, centros acadêmicos e governos na criação de políticas baseadas em evidências. O objetivo é promover o uso responsável da tecnologia de forma coordenada e inclusiva.

Por sua vez, Estados Unidos e Reino Unido seguem caminhos mais flexíveis, com foco na inovação e segurança. Os EUA querem reduzir a dependência da China e controlar a exportação de tecnologias sensíveis. O Reino Unido adota princípios como transparência e justiça, mas ainda sem leis específicas, prevendo uma regulação mais forte no futuro.

Na outra ponta, a China lançou recentemente uma campanha nacional contra o mau uso da IA, focando na remoção de apps não autorizados e na regulação de conteúdo. A iniciativa reforça o controle estatal, buscando garantir o uso ético e seguro da tecnologia. Essa abordagem destaca a forte intervenção do governo para manter a ordem social e política.

E o Brasil? O estágio da regulamentação da IA por aqui

O Brasil está caminhando para ter uma lei específica sobre IA. Trata-se do Projeto de Lei 2338/2023, também chamado de Marco Legal da IA, que foi aprovado no Senado no final de 2024 e, agora em 2025, está sendo analisado pela Câmara dos Deputados. A expectativa é que a discussão avance ainda no primeiro semestre deste ano.

Esse projeto nasceu em 2020, com base em discussões entre especialistas do direito, e ao longo do tempo passou a envolver cientistas, profissionais da tecnologia, representantes de empresas e da sociedade civil.

O texto recebeu centenas de sugestões e chegou à sua versão atual com 80 artigos divididos em 12 capítulos, tornando-se até mais detalhado do que a legislação europeia, que serviu de inspiração para o projeto.

Quais os principais pontos do Marco Legal da IA – PL 2338/2023

A ideia principal do projeto que propõe a regulamentação da IA no Brasil é encontrar um equilíbrio entre o avanço da tecnologia e a proteção dos direitos das pessoas, como a privacidade, a segurança e o uso ético dos dados. Isso é ainda mais importante em áreas onde a Inteligência Artificial já tem grande impacto, como é o caso do setor financeiro.

Entre os pontos principais da proposta, vale destacar:

- Regras proporcionais ao risco: sistemas de IA deverão seguir níveis diferentes de controle, dependendo do potencial de causar danos. Quanto maior o risco à segurança ou aos direitos das pessoas, mais rigor será exigido.

- Transparência e responsabilidade: empresas que desenvolvem ou usam IA precisarão garantir que os sistemas sejam justos, evitem discriminação e operem com clareza.

- Direito à explicação e contestação: quem for afetado por decisões automatizadas terá o direito de entender como a decisão foi tomada, pedir explicações e solicitar uma revisão feita por um ser humano.

- Testes em ambientes controlados: o projeto prevê espaços seguros para experimentar novas tecnologias de IA, com regras mais flexíveis, o que pode facilitar a inovação sem abrir mão da responsabilidade.

Para quem trabalha com tecnologia, dados e algoritmos de decisão, é fundamental acompanhar esse projeto.

Afinal, a regulamentação da IA pode exigir mudanças importantes, como a obrigação de tornar os processos mais transparentes, oferecer formas claras de contestar decisões automatizadas e manter mecanismos de auditoria contínua para evitar discriminações nos sistemas.

Impactos da regulamentação da IA nos serviços financeiros

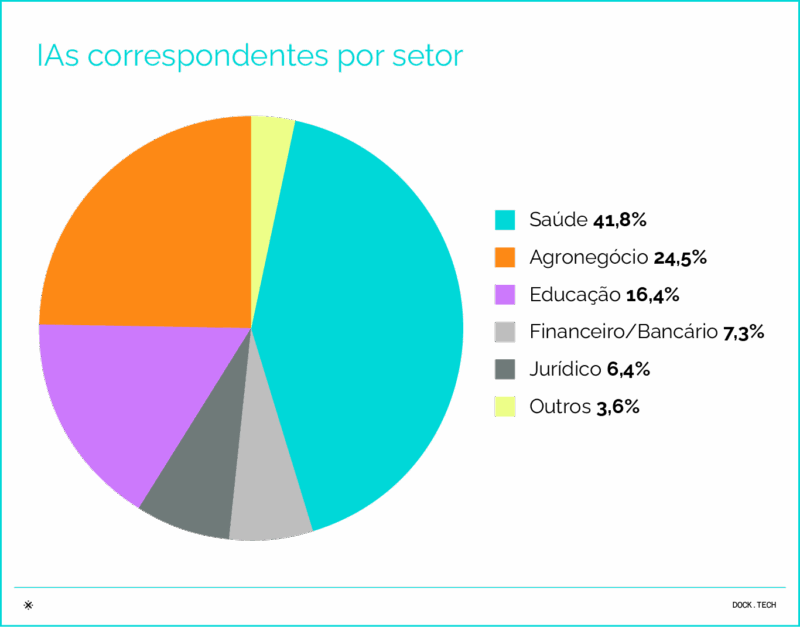

O setor financeiro é um dos que mais utilizam IA no Brasil. De acordo com o relatório do Instituto de Tecnologia e Sociedade do Rio de Janeiro (ITS-Rio), entre as principais áreas que têm adotado iniciativas de IA no Brasil, o setor financeiro ocupa a quarta posição, respondendo por 7,3% das aplicações.

Dessa forma, é natural que esse mercado esteja entre os mais impactados pelas disposições de regulamentação da IA.

O uso de IA já é decisivo, por exemplo, em frentes como concessão de crédito, pagamentos instantâneos, análise de comportamento e KYC (Know Your Customer).

Nessas áreas, a tecnologia automatiza decisões que afetam diretamente o acesso a produtos e serviços financeiros, o que aumenta a responsabilidade das instituições em garantir transparência, supervisão humana e mitigação de riscos.

Possíveis implicações práticas da regulamentação da IA no setor financeiro

- Revisão de modelos de crédito e scoring comportamental para garantir que não violem proibições relacionadas a segmentações discriminatórias ou baseadas em comportamento subjetivo;

- Bancos e fintechs precisarão adaptar seus sistemas de crédito automatizado para incluir processos de revisão humana;

- Soluções de autenticação facial ou comportamental devem garantir que não discriminem usuários nem violem direitos à privacidade. Serviços KYC precisarão ser redesenhados para cumprir os novos critérios legais;

- Instituições que operam no Pix ou sistemas similares de pagamentos instantâneos precisarão avaliar se seus sistemas se enquadram como de alto risco, especialmente se envolverem biometria ou priorização de serviços, e nesse caso, realizar avaliações de risco obrigatórias;

- Fintechs e bancos que usam IA treinada com dados sensíveis ou conteúdos protegidos (como voz e imagem) deverão garantir licenças e consentimentos explícitos, sob risco de sanções legais e judiciais.

Vigência do PL 2338/2023 e penalidades

Uma vez aprovado o projeto de lei, algumas regras entram em vigor em 180 dias, como as que envolvem conteúdos sintéticos, IA generativa, aplicações proibidas de sistemas e direitos de autor. Diante disso, o setor financeiro precisa se antecipar e estruturar mecanismos de governança e conformidade o quanto antes.

De acordo com o Projeto de Lei, empresas que não cumprirem essas diretrizes poderão enfrentar sanções significativas, como multas de até R$ 50 milhões ou 2% do faturamento por infração.

Regulamentação da IA: o que você viu neste artigo

- A inteligência artificial (IA) é fundamental na transformação dos serviços financeiros, especialmente em combate a fraudes, automação e compliance.

- A regulamentação da IA avança globalmente, com marcos legais como o AI Act na União Europeia e debates em andamento no Brasil, pelo Projeto de Lei 2338/2023.

- O marco legal brasileiro busca equilibrar inovação tecnológica e proteção dos direitos das pessoas, impondo regras proporcionais ao risco e exigindo transparência e responsabilidade.

- Instituições financeiras terão que revisar modelos, garantir supervisão humana, e proteger dados sensíveis para evitar sanções previstas na legislação.

- A Dock oferece uma plataforma tecnológica flexível e acompanha as mudanças regulatórias para manter seus clientes em conformidade e na vanguarda da inovação.

Artigos relacionados

- Concierge Commerce: personalização e pagamentos integrados moldam o varejo do futuro

- IA no varejo: prevenção de fraudes e otimização de pagamentos trazem competitividade ao setor

- Buy Now, Pay Later: um modelo com potencial gigantesco na América Latina

- Phygital Banking: como a integração de canais físicos e digitais pode ser estratégica no setor financeiro

- Cartão Global: como funciona e por que a sua oferta é vantajosa para bancos e fintechs